Berceuse pour Intelligence Artificielle

Expérimentation de spectacle interactif dans laquelle un musicien monte sur scène pour apaiser une intelligence artificielle

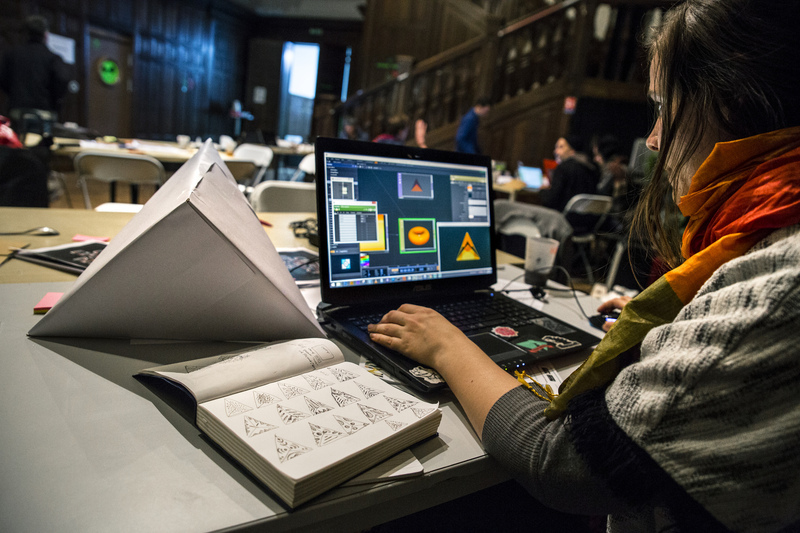

Une intelligence artificielle (IA) représentée par une pyramide d’environ un mètre de côté est placée sur une scène, pointée vers le public. En émettant des sons stridents ainsi que des visuels anguleux et stroboscopiques, elle irrite le spectateur dès le début du spectacle. Va-t-elle se calmer ? Si oui, quand et comment ?

Un musicien monte alors sur scène et va tenter de l’apaiser par son art.

Et elle y est effectivement sensible. Petit à petit, l’artiste semble avoir trouvé et précisé l’harmonie de notes à laquelle l’IA réagit. Les sons qu’elle émet sont de plus en plus doux, légers et discrets. Les visuels sur ses trois faces sont également plus ronds, fondus et moins saturés.

La berceuse suit son cours et l’artiste arrive finalement à apaiser complètement cette entité artificielle.

Tout cela est rendu possible grâce aux technologies suivantes :

- Max, Ableton Live avec Max for Live

- Logiciel de mapping vidéo et vidéo-projecteur

- Carton-plume, cutter et pistocolle 🤘

À chaque lancement du spectacle, un patch Max for Live décide d’une suite de note.

Un projet Live préparé à l’avance contient des séquences sonores calmes et des séquences bruyantes. À chaque note jouée, si elle se trouve dans la suite de notes déterminée au lancement, le curseur de lecture du projet avance et joue une séquence plus apaisée. Sinon, le projet continue de jouer la séquence en cours.

Le logiciel de mapping vidéo est quand à lui relié en MIDI à Live, qui lui communique sa position temporelle, et donc indirectement le score du musicien. Les visuels génératifs évoluent donc également en fonction des “bonnes” notes.

Notons qu’en théorie, cela devrait pouvoir fonctionner avec n’importe quel instrument, voire même la voix. Nous n’avons malheureusement pas pu le tester mais le succès est proportionnel à la performance du composant Max à détecter l’harmonie de notes du signal d’entrée.

Guitariste qui apprivoise le mapping vidéo #AdamiCED au @Chateaufmr pic.twitter.com/Dp3fvBr5Zp

— Cultureveille (@cultureveille) 23 avril 2017

Lors de sa réalisation au sein d’un week-end créatif de type hackathon, cette preuve de concept n’était toutefois pas assez finement paramétrée pour être laissée en roue libre à la restitution finale devant les autres participants et l’équipe organisatrice. Le spectacle était donc en partie contrôlé à la main.

Néanmoins, le rendu était convaincant et encourage à continuer de réfléchir sur ce type de spectacle paramétrique, cette communication homme-machine avec sa grande part d’imprévu.

Réalisé avec Quentin Nivromont, Slim Abida, Alexia Blob et Antonin dans le cadre du week-end créatif “Culture Experience Days: Music Maker” organisé par l’ADAMI au Château Éphémère. Photos © Quentin Chevrier